Le développement de l’informatique marqué par 4 grands changements de paradigmes

L’informatique a connu 4 grands changements de paradigme qui nous ont mené à notre contexte technologique actuel :

-

1984 – Ordinateurs et Internet: L’Internet démocratise l’usage des ordinateurs dans nos modes de vie sur les plans personnels et professionnels. On constate une augmentation forte de la productivité individuelle et collective, tout en donnant naissance à de nouvelles économies de marchés telle que celle du e-commerce.

-

2007 – Révolution du smartphone: Une nouvelle économie naissante avec la sortie de l’iPhone par Apple, qui débloque des scenarios de mobilité modernes, transformant nos vies personnelles et impactant également les stratégies de communication et de travail au sein de nos organisations

-

2012 – Cloud Computing: Émergence du Cloud Computing qui va permettre un déploiement beaucoup plus massif et rapide des usages digitaux dans notre environnement professionnel et personnel. De nouveaux scénarios apparaissent autour de la mobilité, la création d’applications et l’exploitation de larges quantités de données.

-

2023 – Ere de l’IA Générative: Maturité des Large Language Model (LLM) avec des mises en application concrète et une accélération fulgurante liée notamment à l’alliance entre Open AI et Microsoft. Le moteur GPT est accessible par le grand public et ses capacités bouleversent les opportunités et champs d’application.

Des innovations techniques pour accompagner ces changements

Ces révolutions majeures n’ont pu se pérenniser qu’avec le support d’innovations techniques majeures sur le plan du matériel et notamment des microprocesseurs.

- La démocratisation d’internet et des ordinateurs s’est accompagnée d’une augmentation exponentielle des puissances de calcul et d’une miniaturisation de l’empreinte physique des machines, jusqu’à les rendre transportables puis portables. C’est la matérialisation de la loi de Moore. La loi de Moore est une observation empirique qui décrit l’évolution de la puissance des circuits intégrés, notamment des microprocesseurs, depuis les années 1960. Elle a été formulée par Gordon Moore, l’un des fondateurs d’Intel, en 1965. Selon cette loi, le nombre de transistors dans un circuit intégré double environ tous les deux ans, ce qui se traduit par une augmentation exponentielle de la performance et une diminution du coût par fonction. La loi de Moore n’est pas une loi physique, mais une tendance historique qui a été vérifiée jusqu’à il y a 10 ans environ. Elle a permis de prévoir l’évolution des technologies de l’information et de la communication, ainsi que leurs impacts économiques et sociaux.

- La révolution du smartphone initiée par l’iPhone devient possible grâce à la sophistication des composants mobiles ayant permis de resserrer l’écart de puissance entre les ordinateurs traditionnels et des dispositifs mobiles.

Bien entendu, ces innovations technologiques ne se sont pas faites du jour au lendemain et se sont étalées sur au moins une décennie à chaque fois. En prenant en compte cette réalité, nous pouvons déduire que l’ère de l’IA Générative aura, elle aussi, son lot d’innovations techniques pour ancrer durablement cette dans le paysage informatique. Les premiers signes de ces ruptures technologiques se manifestent déjà depuis quelques années, mais avant de s’y attarder, je pense qu’il est important de comprendre pourquoi nous ne pouvons pas nous satisfaire du contexte technologique actuel pour une démocratisation de l’IA Générative à très grande échelle.

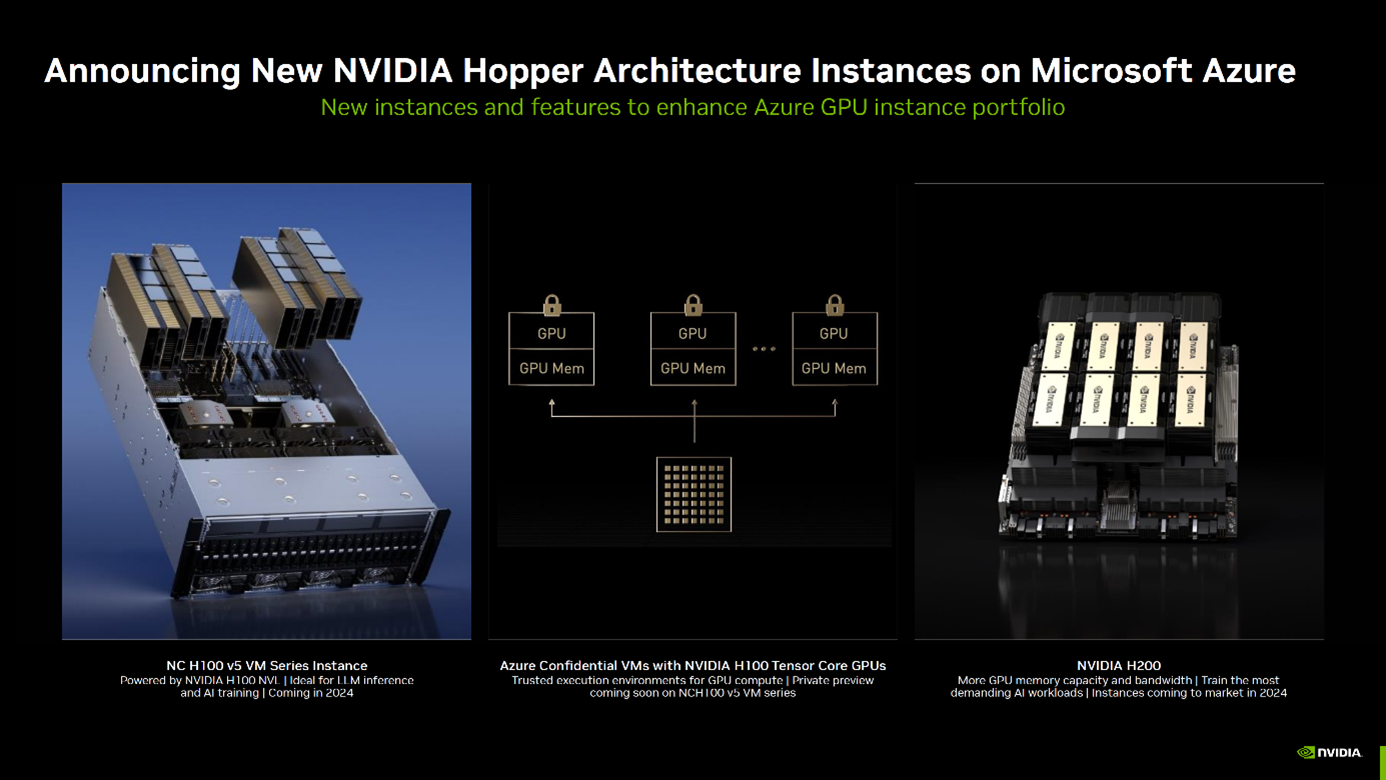

Une architecture décentralisée qui montre ses limites

L’IA Générative repose aujourd’hui sur des infrastructures pensées pour le Cloud Computing. Cela a un énorme avantage, car les sociétés comme Open AI et Microsoft peuvent compter sur une importante puissance de calcul déjà en place pour entraîner les fameux LLM permettant à ChatGPT ou encore Microsoft 365 Copilot de fonctionner. Des acteurs comme Nvidia ont rendu possible l’amélioration des infrastructures existantes en fournissant à Microsoft leurs nouvelles unités de calculs. En effet, au cœur de la technologie d’OpenAI, il y a le cloud Azure de Microsoft et des milliers de machines appelées « ND H100 v5 ». Sous ce nom technique, se cache un module matériel surpuissant. Un serveur équipé de :

- Processeurs Intel Xeon Scalable de 4e génération

- Processeurs qui sont à l’origine responsables de l’essentiel des calculs, à savoir des GPU de Nvidia spécialement conçu pour les tâches liées à l’IA.

Si Microsoft ne communique pas le nombre ni la nature des d’Intel, on sait que chaque serveur intègre au moins huit H100 de Nvidia. Soit 640 milliards de transistors (80 milliards par GPU) interconnectés par les technologies NVSwitch et NVlink pour diviser les temps de calcul jusqu’à neuf fois par rapport aux GPU A100, de 2020. Ou comment transformer des mois de calculs en quelques semaines. (src. Pour ChatGPT, Microsoft a dépensé des millions de dollars… en GPU Nvidia (01net.com)).

Au-delà de l’investissement massif que cela représente pour mettre à jour les infrastructures existantes, il y a 2 questions supplémentaires qui se posent :

- L’impact environnemental : Les unités de calculs spécialisées pour l’entraînement et l’exécution des modèles d’IA Générative sont extrêmement énergivores. Un seul module ND H100 v5 de Nvidia peut consommer à lui seul 700 watts : ce dernier est pensé pour fonctionner en parallèle avec jusqu’à 255 autre module ND H100 v5 supplémentaire.

Autre exemple : l’année dernière, il a fallu l’équivalent de 502 tonnes d’émissions de CO2 pour l’entraînement de GPT-3, le modèle alimentant ChatGPT. Cela représente environ 500 allers/retours Paris-New-York. Au milieu de l’été, un rapport de la Commission sur l’eau et l’énergie irlandaise (la CRU, Commission for Regulation of Utilities in Ireland) est venu troubler la croissance fulgurante de l’industrie de la donnée. On y apprend que la consommation électrique des data centers passera de 11 % à 27 % de la consommation électrique nationale d’ici à 2028.

Si rien n’est fait pour réguler leur installation, « cela entraînera probablement une situation où la demande dépasse l’offre disponible lors des pics de consommation et entraînera des délestages, les consommateurs seront confrontés à des pannes de courant ». L’utilisation du terme « black-out » a eu un effet d’électrochoc. « Il faut comprendre qu’un data center représente la consommation d’une ville moyenne comme Kilkenny (26 000 habitants) », décrypte le professeur Patrick Bresnihan de l’université de Maynooth.

Les données prévisionnelles avancées par la CRU prennent en compte uniquement « les data centers actuels, et les projets déjà en construction ou dont le dossier de raccordement a été accepté. Mais d’autres sont encore en attente d’autorisation », précise l’universitaire à Reporterre. (src. Trop de « data centers », l’Irlande risque la panne électrique (reporterre.net))

- La rentabilité économique : Selon le Wall Street Journal, Microsoft perdrait en moyenne 20 dollars par utilisateur de Copilot GitHub et par mois. Sa commercialisation a été lancée après une longue phase de test en juin 2022 au prix de 10 dollars par mois ou 100 dollars par an pour les développeurs. Il est gratuit pour les étudiants (sous réserve de vérification) et les responsables de projets open source.

Une version Business a même été proposée en décembre 2022 au prix de 19 dollars par utilisateur et par mois. Elle comprend les mêmes fonctionnalités que la déclinaison grand public, mais avec des éléments de contrôle supplémentaires. (src. Copilot de GitHub, un service loin d’être rentable pour Microsoft – Le Monde Informatique)

Des coûts d’exploitations importants qui s’expliqueraient en partie par le coût énergétique induit par les unités de calculs spécialisés nécessaires au fonctionnement de ces nouveaux modèles d’IA Générative.

Nous voyons bien que cette approche n’est ni tenable d’un point de vue environnemental, ni d’un point de vue économique si l’adoption des utilisateurs continue de croitre comme aujourd’hui.

Comment techniquement soutenir cette nouvelle ère d’IA Générative ?

Pour répondre à cette question, il faut prendre ce problème d’infrastructure à la base en se concentrant sur l’élément le plus important : les unités de calcul.

Les unités de calculs sont un regroupement de transistors permettant aux ordinateurs de réaliser des opérations mathématiques nécessaires au bon fonctionnement des logiciels et services que nous utilisons au quotidien.

Que cela soit notre tableur Excel, nos sessions de binge-watching de séries Netflix ou l’analyse du génome humain par des scientifiques : les unités de calculs sont au centre.

Les unités de calculs sont rangées par famille : les plus populaires étant les CPU (Central Process Unit) et les GPU (Graphic Process Unit) où règnent en maîtres absolues 3 grands acteurs : Intel, AMD et Nvidia. Ces unités de calculs ont très longtemps suivi la loi de Moore mentionnée un plus haut dans l’article. Si cette loi était assez juste pendant plusieurs décennies, nous constatons depuis un peu moins de 10 ans que nous atteignons les limites physiques de ce qu’il est possible de faire en termes de concentration de transistors.

Lorsque la loi de Moore a été conçue à l’origine, l’informatique était relativement nouvelle et passionnante. Toute corrélation entre le climat et l’énergie consommée par les ordinateurs n’était la priorité de personne – principalement parce que si les ordinateurs étaient des bêtes gourmandes en énergie, il y en avait relativement peu. Au 21ème siècle où la connectivité est devenue une nécessité de base, essentielle pour tout, de l’information médicale à l’épicerie, la situation n’est plus la même. L’accès à Internet est synonyme d’opportunités : l’information est partagée en ligne, l’apprentissage se fait en ligne, les offres d’emploi sont publiées en ligne… Essentiellement, si vous n’êtes pas en ligne, vous passez à côté de quelque chose.

Les centres de données dans leur ensemble sont limités par leur capacité à dissiper l’énergie thermique, tandis que les serveurs individuels ont des limites de puissance. Les appareils mobiles sont limités par l’énergie stockée dans leurs batteries, tandis que leur puissance instantanée est limitée par des contraintes thermiques. La loi de Koomey, inventée en 2010 et nommée en l’honneur du professeur Jonathan Koomey de Stanford, décrit une tendance dans le nombre de calculs par joule d’énergie dissipée. Ce nombre a doublé tous les 18 mois de 1945 à 2000 soit 100 fois par décennie, puis a ralenti, doublant tous les 2,6 ans environ depuis. (src. Performance Per Watt is the New Moore’s Law – Arm Newsroom).

« Un grand pouvoir, implique de grandes responsabilités. » (durables)

Nous nous attendons à ce que nos appareils aient un certain profil de puissance, même si la loi de Moore augmente leur capacité de calcul. La loi de Koomey est sans doute plus pertinente pour la façon dont nous percevons l’informatique aujourd’hui – et la façon dont nous devrions construire les technologies de demain.

Notre vie numérique a tendance à s’étendre sur plusieurs appareils, où l’autonomie de la batterie et les performances par watt sont plus importantes que les performances brutes seules. Cela se reflète dans les priorités des fabricants qui concentrent de plus en plus leurs efforts sur l’augmentation de l’efficacité : la nécessité de se concentrer sur la décarbonisation du calcul (réduire l’emprunte carbone des calculs informatiques) n’a jamais été aussi grande. (src. Performance Per Watt is the New Moore’s Law – Arm Newsroom) »

L’industrie des smartphones est la parfaite matérialisation de la loi de Koomey.

Un smartphone doit fonctionner sur batterie le plus longtemps possible, doit être le plus portable possible et être refroidit passivement. ARM et ses partenaires comme Apple, Qualcomm et Mediatek ont usé de plusieurs tactiques pour allier efficience énergétique et puissance de calcul en démocratisant notamment l’approche SoC.

Un SoC (System on Chip) est un circuit intégré qui regroupe sur une seule puce les principaux composants d’un système électronique. Il peut contenir un ou plusieurs processeurs, de la mémoire, des périphériques d’entrée/sortie, des interfaces de communication, etc. Le SoC permet de réduire la taille, le coût et la consommation électrique du système, tout en augmentant ses performances et sa fiabilité. Dans les débuts, l’architecture des SoC était assez simples et imitait ce qui se faisait depuis des années du côté des ordinateurs traditionnels : proposer un CPU, un GPU et de la mémoire vive. Au fil des années, les SoC ont vu la naissance d’unité de calcul de plus en plus spécialisées et pensées pour traiter des tâches bien spécifiques de manière beaucoup plus efficiente que le gourmant couple CPU/GPU.

Par exemple, les SoC de nos smartphones possèdent tous aujourd’hui des ISP qui sont des unités de calculs spécialisées dans le traitement des images captés par l’appareil photo. Avance rapide jusqu’à aujourd’hui et nous pouvons voir à quelle point l’approche SoC est aujourd’hui mûre et efficiente.

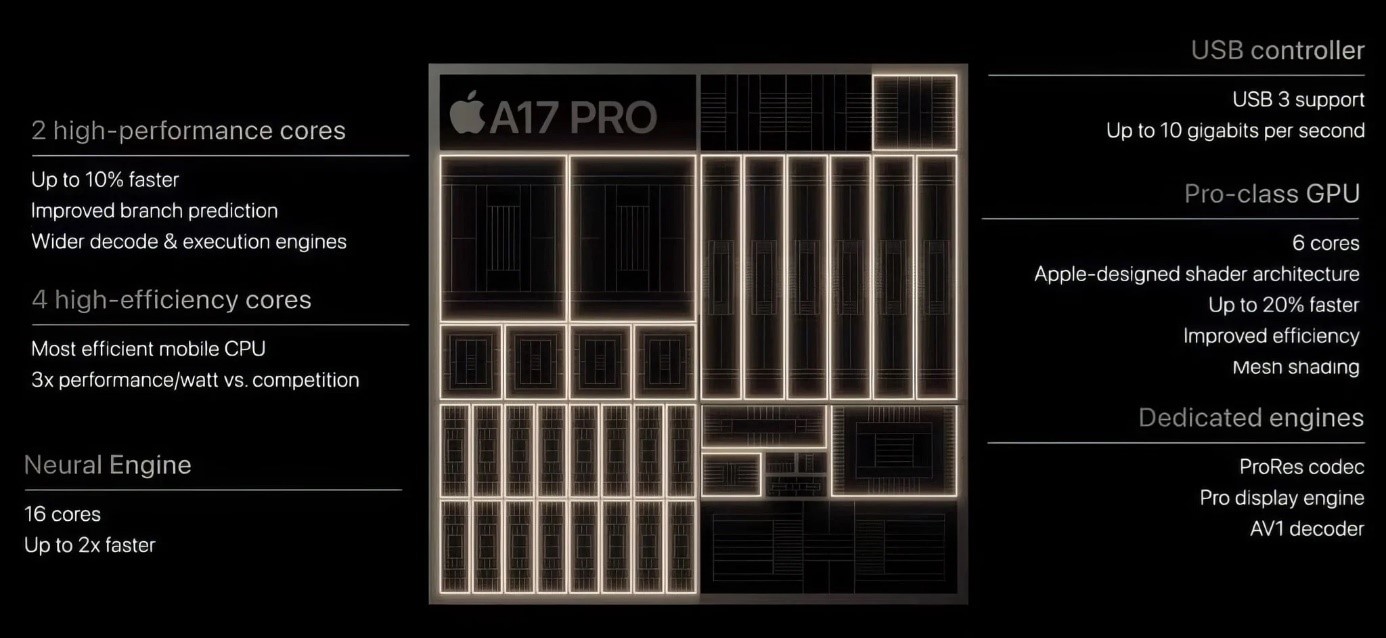

La dernière puce maison Apple A17 Pro présente dans la gamme d’iPhone 15 Pro possèdent aujourd’hui un ensemble d’unités de calculs spécialisées :

- Un cluster de CPU hautes-performances pour les tâches exigeantes

- Un cluster de CPU hautes-efficiences pour les tâches du quotidien

- Un ISP pour le traitement des photos

- Une unité dédiée à la gestion du (protocole de transfert de données via USB)

- Un GPU avec des unités spécialisées pour le traitement des shaders et ray-traycing (méthodologie moderne permettant d’obtenir de meilleur rendu graphique pour le premier et une simulation réaliste des particules de lumière pour le second)

- Une unité dédiée pour l’encodage et le décodage de codec vidéo

- Une unité dédiée pour traiter les animations de l’interface utilisateur

- Un NPU pour le traitement de tâches dédié à l’intelligence artificielle

Cette dernière unité de calcul est très intéressante, car c’est une tendance que nous observons depuis ces 5 dernières années. Appelés NPU (Neural Process Unit) chez certains et TPU (Tensor Process Unit) chez d’autres, ces unités de calculs sont conçues pour exécuter les tâches d’intelligences artificielle dans une enveloppe énergétique très contenue en comparaison avec les GPU plébiscité dans infrastructures cloud entre autres.

Le NPU fonctionne en simulant les neurones et les synapses humains au niveau de la couche de circuit et en traitant directement les neurones et les synapses à grande échelle avec un jeu d’instructions d’apprentissage profond, où une instruction complète le traitement d’un ensemble de neurones

Les processeurs CPU et GPU doivent utiliser des milliers d’instructions pour terminer le traitement des neurones. Le NPU peut être programmé par quelques instructions seulement, ce qui présente des avantages évidents en termes d’efficacité de traitement de l’apprentissage profond. Les résultats expérimentaux montrent que les performances du NPU sont 118 fois supérieures à celles du GPU avec la même consommation d’énergie. (src. Neural Processing Unit (NPU) Explained – Utmel)

Les NPU sont disponibles depuis déjà quelques années dans nos smartphones et sont aujourd’hui de plus en plus sollicité pour soulager le couple CPU/GPU tout en proposant des performances supérieures pour une emprunte énergétique bien inférieurs. C’est ce qui a permis à Google de doubler la quantité de modèle de machine learning exécutés localement par son dernier smartphone plutôt que de les « offshoriser » vers une infrastructure cloud.

C’est le cas par exemple du Magic Editor présent dans l’application Photos du Google Pixel 8 qui applique les traitements grâce à la puissance locale de son TPU. Cette tendance existe depuis 2020 dans nos ordinateurs avec Apple notamment qui a basculé toute sa gamme d’ordinateurs sur une architecture ARM avec une approche SOC et où des éditeurs profitent déjà des bienfaits du NPU.

Qualcomm de son côté a récemment annoncé son nouveau SoC destiné aux PC sous Windows : Snapdragon X Elite. La puce de Qualcomm est capable d’exécuter localement des modèles d’IA Générative comme LAMA avec plus de 13 milliards de paramètres ou des modèles d’IA Générative à 7 milliards de paramètres tout en gérant 30 tokens par seconde : le tout dans une enveloppe comprise entre 25 et 85 watts maximum.

Ces avancées montrent une chose : compter exclusivement sur les infrastructures cloud traditionnelles pour le développement et la généralisation de l’IA Générative n’a pas de sens et n’est surtout pas viables pour les raisons vues plus en amont. Pour qu’une généralisation massive puisse se faire tout en limitant de façon significative les impacts environnementaux, il sera nécessaire de travailler sur 2 axes :

- Privilégier les traitements locaux : profiter des puissances de calculs de nos ordinateurs et de nos smartphones pour exécuter les actions permises par l’IA Générative. La mise à jour des modèles pourrait se faire alors avec la mise à jour de notre système d’exploitation ou comme une application tout simplement. Pour que ceci soit valable il faudra bien entendu qu’en plus de Qualcomm et Apple, d’autres acteurs poussent une approche SoC avec un module NPU/TPU intégré dans nos futurs ordinateurs. Des signes encourageants semblent se présenter avec Intel qui a par exemple très récemment annoncé ces nouveaux processeurs de 14ème génération destinés au grand public et doté d’un NPU.

- Améliorer et spécialiser les infrastructures cloud : de mon point de vue, les infrastructures Cloud actuel dans le cadre de l’IA Générative doivent uniquement être utilisées pour entraîner des modèles ou pour traiter des opérations IA très complexes et coûteuses dans certains cas bien spécifiques comme le domaine de la recherche médicale par exemple : utiliser les infrastructures cloud comme des supercalculateurs.

Les infrastructures cloud doivent aussi de mon point de vue se détourner des architectures traditionnelles comptant presque exclusivement sur le couple CPU/GPU et explorer l’approche SoC pour améliorer leur efficience. Dans cet exercice, Microsoft a frappé un grand coup durant l’Ignite 2023 en officialisant 2 puces maisons : - Microsoft Azure Cobalt : Premier CPU in-house basé sur l’architecture ARM, ce dernier est un processeur 64 bits doté de 128 cœurs consommant 40% d’énergie en moins par rapports aux puces utilisées par Azure jusqu’à présent qui elles-mêmes consommaient déjà moins que les CPU AMD et Intel. Microsoft fait même déjà tourner des instances de Microsoft Teams et Azure SQL sur ces architectures.

- Microsoft Azure Maia : puce entièrement conçue pour l’IA générative, cette dernière propose une finesse de gravure quasi inédite dans le milieu des infrastructure Cloud : 5nm. Pour rappel, une gravure fine est synonyme d’une efficience énergétique plus importante. Elément important, Open AI a participé à l’élaboration de cette puce inédite. Peu de détails pour le moment notamment sur l’architecture exacte utilisée, mais le fait que cette puce n’est pas un dérivé de GPU peut nous laisser espérer des de bonnes performances dans une enveloppe thermique et énergétique contenue. Microsoft dans cette démarche s’aligne avec Google qui propose depuis déjà quelques années des TPU dédiés à l’IA.

Je vous présente de gauche à droite : Microsoft Azure Maia et Microsoft Azure Cobalt

Si le succès de l’IA Générative n’est déjà plus à prouver son utilisation massive dans les conditions actuelles restent un défi à relever. La croissance des infrastructures cloud ayant des limites physiques il est important de repenser l’exploitation de ces nouvelles IA et le développement d’AGI à terme (Artificial General Intelligence : représentation des capacités cognitives humaines généralisées dans un logiciel afin que, face à une tâche peu familière, le système d’IA puisse trouver une solution. Un système AGI pourrait théoriquement effectuer n’importe quelle tâche dont un humain est capable.).

Optimiser les infrastructures cloud actuelles et surtout relocaliser le traitement des prompts sur nos devices me semble crucial pour proposer une expérience utilisateur optimale et surtout adresser le défi de l’impact environnemental de ces solutions. Bien entendu, cela prendra du temps mais nous pouvons déjà voir que des acteurs comme Microsoft, Apple, Qualcomm, Intel, etc. s’oriente vers cela.

En parallèle de cela comme expliqué dans mon précédent article, il est, je pense, de notre devoir de challenger nos usages.

Avons-nous besoin de solliciter une IA Générative pour toutes nos actions du quotidien ? A titre d’exemple un besoin peu complexe adressé par une intelligence artificielle qui apportera une faible valeur ajoutée aura un important impact écologique : cela reviendrait à allumer une bougie en utilisant un lance flamme plutôt qu’une allumette…

Nous ne devons pas stopper l’évolution de nos usages mais nous devons prendre conscience que ces évolutions ont un coût écologique de moins en moins négligeable.

Ecrit par Kévin ANANDOUT, Consultant Digital Senior | Team Lead chez Expertime